Introduction

한국 농촌경제연구원에서 발표한 ‘2021 농업, 농촌 국민의식 조사’에 따르면 농업인과 도시민의 관계없이 약 80% 이상이 국가 경제에서 농업의 위상이 높아질 것으로 보고하였다. 하지만 통계청 자료에 따르면(Statistic Korea, 2021) 국내의 농촌은 고령화와 인구 감소로 인하여 작물 생산의 문제점을 겪고 있으며 높은 투자비용으로 인한 대안이 필요하다. 따라서 효율적인 농업을 위해 기존의 기술과 현대의 기술을 혼합하는 것이 중요하다. IoT (Internet of Things)와 ML (Machine Learning)을 활용하는 농업의 현대화로 이어지고 있으며 다양한 기계 및 농업 노동력 부족을 해결하기 위해 사용되고 있다(Raj et al., 2021).

정밀농업은 온습도 센서, 수확량 센서, 토양 센서 등 다양한 데이터 수집 장비가 농업 목적으로 개발되었지만 정밀농업 분야에서는 이미지 센서가 가장 중요하다(Kumar et al., 2018). 이미지 센서로 취득된 데이터를 토대로 원격감지, GPS 및 지리정보 시스템 등을 사용하여 농작물을 모니터링 하는 것은 정밀 농업의 시작 단계이다(Harsh et al., 2021). 다양한 이미지 데이터는 위성이나 항공기에 장착된 센서를 이용하여 공간의 변동성을 나타낼 수 있는 식생 지수(Normalized Difference Vegetation Index, NDVI)를 계산할 수 있다(Hassler et al., 2019). 하지만 위성 또는 항공기를 사용하여 취득한 데이터는 높은 비용과 낮은 해상도로 인해 불안정한 경우가 많다. 최근에는 이를 보완할 수 있는 UAV (Unmanned Aerial Vehicle)를 이용하여 이미지 데이터를 취득하고 있다. UAV은 인력을 줄이고 시간을 절약할 수 있으며 무엇보다도 비용이 저렴하며 고해상도의 모니터링 시스템을 UAV에 탑재할 수 있는 장점이 존재한다(Gupta et al., 2022). 최근에는 UAV에 시스템을 탑재한 UAS (Unmanned Aircraft System)의 기술이 등장하였으며 UAS 기술은 현장 맵핑, 식물 스트레스 감지, 바이오매스 평가, 잡초 관리, 비료 살포 등 다양한 농업 작업에 대해 보다 통합되고 최적화된 기술로 평가받는다(Gupta et al., 2013).

본 논문에서는 UAV를 활용하여 취득된 영상 데이터와 인공지능 기술을 활용하여 농업 공간정보를 구축하고 벼 생육 및 작황정보를 모니터링 및 예측 기술을 개발하는데 있다.

Materials and Methods

드론 영상 취득 데이터 정제 및 작황정보 현장조사

벼의 작황정보 예측 모델 개발을 위한 데이터 획득 장소는 2021년 신품종벼를 재배중인 농가 56필지, 201,347 m2 를 포함한 약 1.3 km2면적의 전라남도 해남군 옥천면 송산리, 청산리 일원과(Fig. 1) 전라북도 익산시 하나로15길 179-25의 약 1.12 km2의 면적과 서동로 414일대의 약 0.06 km2를 대상지로 선정하였다(Fig. 2).

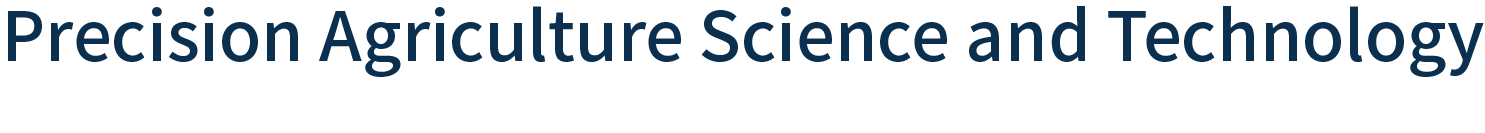

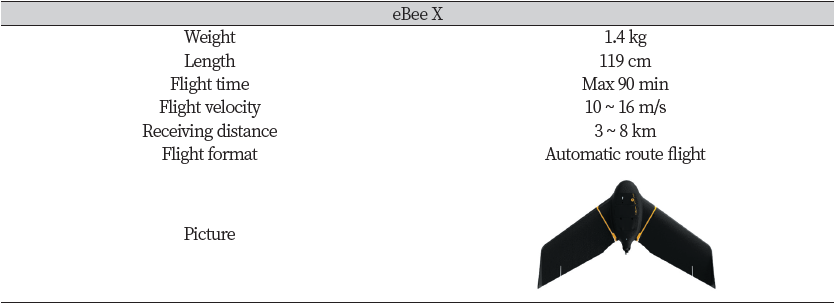

넓은 지역의 원활한 촬영을 위해 장시간 비행이 가능한 고정익 무인 비행기 eBee X와 회전익 무인 비행기 Matric 300을 이용하여 촬영하였다. 고정익 드론인 eBee X는 무게 1.4 kg의 드론으로 길이는 약 119 cm, 비행시간은 90분, 비행속도는 10~16 m/s 속도로 비행이 가능하며 1회 비행시 비행면적은 약 0.05~10.0 km2이고, 수동 이륙 및 자동 착륙, 비행은 사전에 입력된 정보에 의한 자동경로비행을 수행한다(Table 1). 회전익 드론인 Matrice 300은 무게 6.3 kg의 드론으로 길이는 약 89.5 cm, 비행시간은 55분, 비행속도는 17~23 m/s 속도로 비행이 가능하며 수동 이륙 및 자동 착륙이 가능하다(Table 2). 비행은 사전에 입력된 정보에 의한 자동경로비행을 수행하게 된다. 촬영센서는 RGB 및 열화상 센서(Duet-T, AgEagle Aerial Systems Inc., North Wichita, Kansas, USA), 다중 분광센서(Rededge-MX, MicaSense, Seattle, WA, USA)이며 행고도는 130 m, 150 m의 고도에서 촬영을 진행하였다. RGB 및 열화상센서는 해상도는 20MP이며, 화각 64°, 저장 포멧은 JPEG로 저장된다. 다중 분광센서는 RGB, NIR, Rededge의 밴드로 구성되어 있으며, 해상도는 1.2 MP, 화각 47.2°, 저장 포멧은 tif로 저장된다.

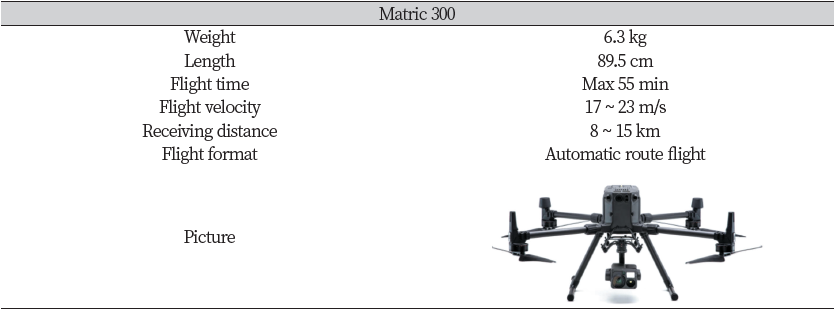

해남군의 데이터 획득은 2021년 8월부터 수확기인 2021년 10월까지 장마 시기를 제외하여 2주 간격으로 시계열 촬영을 진행하였으며, 익산시의 데이터 획득은 2021년 10월 6일~ 7일간 시계열 촬영을 진행하였다(Fig. 3).

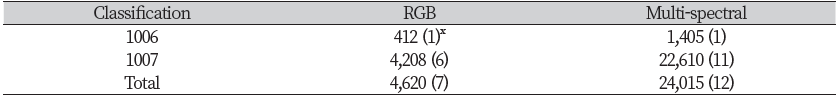

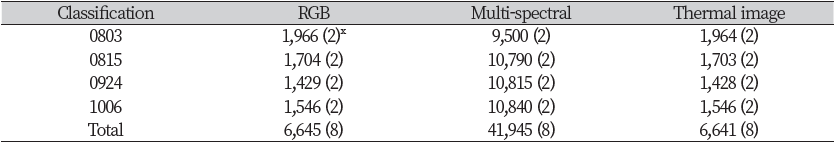

벼의 작황정보에 대한 현장조사는 드론 영상 취득시기와 유사한 시기에 ‘해남군 농업기술센터’와 연계하여 토양 비료사용 처방서와 품질 생육조사를 실시하였으며 필지 별, 품종 별 키, 줄기 수, 포기당 이삭 수, 이삭당 낱알 수의 조사 결과를 제공받았다. 전라남도 해남군은 4번의 촬영을 진행하였으며 RGB 센서의 사진매수는 6,645매, 다중 분광 센서의 사진 매수는 41,945 매, 열화상 센서의 사진 매수는 6,641매로 총 55,231개의 데이터를 획득하였으며 이 때 총 비행 횟수는 24회 실시하였다(Table 3). 전라북도 익산시는 2번의 촬영을 진행하였으며 RGB 센서의 사진 매수는 4,620매, 다중 분광 센서의 사진 매수는 24,015매로 총 28,635개의 데이터를 획득하였으며 이때 총 비행횟수는 19번으로 기록되었다(Table 4).

|

Table 3. Number of photos taken and lights by Haenam-gun

|

|

x Numbers in () mean the number of flights. |

드론 영상취득 데이터 전처리 및 정제

지리정보가 포함된 Shape파일 형태인 스마트팜 맵(SmartFarm Map)을 기반으로 촬영 대상 지역의 필지 단위 경계를 작성하였다. 스마트팜 맵의 shape파일은 영상 이미지를 배경으로 필지 형태에 맞추어 편집하였으며 shape파일과 영상처리가 완료된 정사 영상 데이터를 오픈소스 기반의 공간정보 편집 도구인 QGIS (Quantum Geographic Information System, https://qgis.org/)프로그램을 활용하여 중첩하였다.

AI 학습 데이터셋 구축

학습용 데이터를 구축하고 분류한 뒤 학습모델을 선정하고 AI를 구축하여 모델 개발을 진행하였다. 영상 전처리 후의 필지단위 타일링 가공 데이터에 작황정보 현장조사 라벨링 데이터를 중첩하였으며, 작물 필지와 그 외 지역 구분을 위한 필지 외곽선 추출 작업을 진행하였다. 테이블 구성 및 이미지 마스킹에 대한 메타정보를 입력하였으며 마스킹 이미지 데이터의 파일변환 및 어노테이션 메타정보데이터 변환을 진행하였다. 작물 및 재배면적 정확한 판독을 위해 재배 필지와 수확 필지를 구분하여 태깅하였다(Fig. 4).

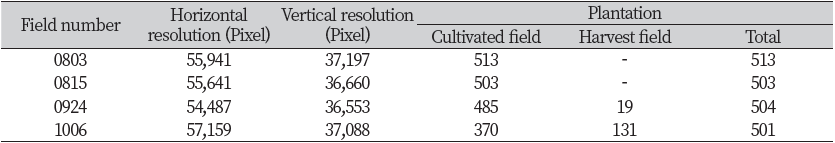

드론으로 촬영된 영상과 태깅된 데이터를 딥러닝 모델 학습에 사용하기 위해 변환작업이 필요하다. 드론 영상은 일정 크기(512 × 512 Pixel)로 그리드 분할하고, 태깅된 데이터는 마스킹 이미지로 변환하여 그리드 분할을 진행하였다(Table 5). 그리드 분할된 이미지와 마스킹 이미지는 학습과 테스트의 데이터 비율은 75:25 비율로 학습 이미지 데이터셋 21,163개와 테스트 이미지 데이터셋 7,055개로 분류하였다.

AI 모델 선정

농작물 생육상태 진단 및 품질, 수확량 예측 분석 모델 개발을 위한 Classification & segmentation regression analysis 모델을 적용하였다. 선정된 벼 농작물 판독 및 인식 모델인 U-Net 모델을 이용하였으며 딥러닝 기술 기반의 이미지 분할 기술 중 Semantic segmentation 기술을 활용하여 이미지 분할 방법을 적용하여 벼 판독 및 재배면적을 산출하였다. 이미지 Segmentation 모델의 주요 학습 가중치는 Epoch, Batch_size, Image_size, Optimizer의 총 4개로 구성하였다 Epoch 값은 200, Batch_size는 8로 적용하였다. Image size는 학습 머신의 GPU 메모리, Batch_size, 학습 시간을 고려하여 512 × 512 Pixel로 적용하였다. 마지막으로 Optimizer은 Adam으로 적용하였다. U-Net 모델 학습의 입력 변수는 작물 판독 및 재배면적, 출력 변수는 재배지와 배경이 구분된 Gray scale 이미지로 지정하여 모델 학습을 진행하였다.

학습모델 유효성 검증

작물 분류 및 재배면적 평가를 위한 지표로 mIoU (Mean intersection over union)지표를 사용하였다. MIoU는 IoU (Intersection over union)을 계산한 후 클래스별로 평균한 값이다. 이 때 IoU는 실제 값과 예측 값이 얼마나 차이 나는지를 표현한 값이다.

IoU = Area of overlap/Area of union (식1)

mIou = IoU / Mean of class value(식2)

Results and Discussion

AI 모델 훈련 및 결과

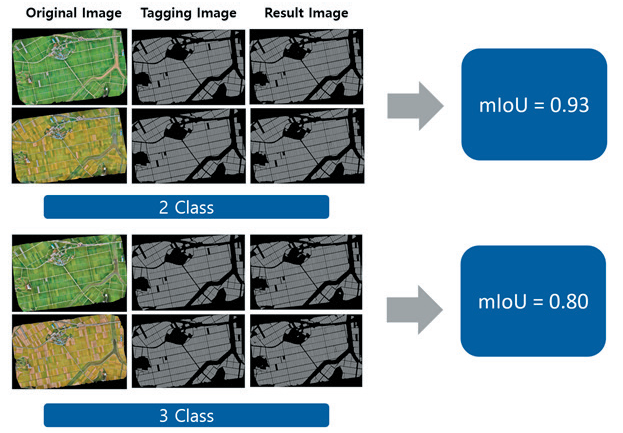

작물 판독 및 재배면적 산출 모델 훈련을 위해 모델 훈련용 Docker image를 활용하였다. 사용된 U-Net 활용모델의 입력 변수는 작물 판독 및 재배면적 이였으며 출력은 재배지와 배경이 구분된 Gray scale 이미지로 지정하였다. 작물 판독 및 재배면적은 2개의 클래스와 3개의 클래스를 각각 AI훈련 후 결과를 확인하였다. 2개의 클래스로 구축한 학습데이터에 대한 학습률은 검증 데이터의 IoU score 기준 99% 이상의 높은 점수를 보였으며 mIou 지수는 0.93이 도출되었다. 3개 클래스로 구축한 학습 데이터에 대한 학습률은 검증 데이터의 IoU score 기준 약 95% 수준으로 나타났으며 mIou 값은 0.80으로 도출되었다. 3개의 클래스로 구축한 학습데이터에 대한 학습률은 2개의 클래스보다 성능이 저조함을 보였다(Fig. 5, 6).

본 연구에서 진행된 벼 생육 및 작황정보 모니터링 및 예측 기술을 개발하기 위한 AI 모델의 성능은 우수한 편이 아니다. 따라서 추가적인 알고리즘을 이용하여 모델의 성능을 높일 필요성이 있다. 이를 수행하기 위해선 재촬영 및 추가 생육조사를 통한 부족한 학습데이터를 확보하거나 한정적 데이터 확장 방법인 Data argumentation을 통한 학습데이터 수량 확보가 필수적이다.

Conclusion

본 연구는 UAV를 활용하여 취득된 영상 데이터와 인공지능 기술을 활용하여 농업 공간정보를 구축하고 벼 생육 및 작황정보를 모니터링 및 예측 기술을 개발하기 위한 기초 연구로서 수행되어 그 결과를 요약하면 다음과 같다.

작물 판독 및 재배면적 산출 모델 훈련을 위해 U-Net 모델을 활용하여 학습 및 모델을 개발하였으며 2개의 클래스와 3개의 클래스에 각각 인공지능 훈련을 진행하였다. 2개의 클래스로 구축한 학습데이터에 대한 학습률은 IoU Score 99% 이상, mIoU 지수는 0.93으로 나타났으며 3개의 클래스로 구축한 학습데이터에 대한 학습률은 IoU Score 95%, mIoU 지수는 0.80으로 나타났다. 따라서 2개의 클래스로 학습하여 결과를 도출하였을 때 AI 모델 평가가 우수하게 나타났다. 본 연구는 한정적 데이터를 사용하여 예측 모델 개발을 진행했으므로 성능이 우수한 편은 아니다. 따라서 농작물 및 추가 생육조사를 통한 부족한 학습데이터를 확보하며 한정적인 데이터 확장 방법인 Data argumentation을 통한 학습데이터 수량 확보를 진행함으로써 모델 성능에 대한 개선이 필요하다.